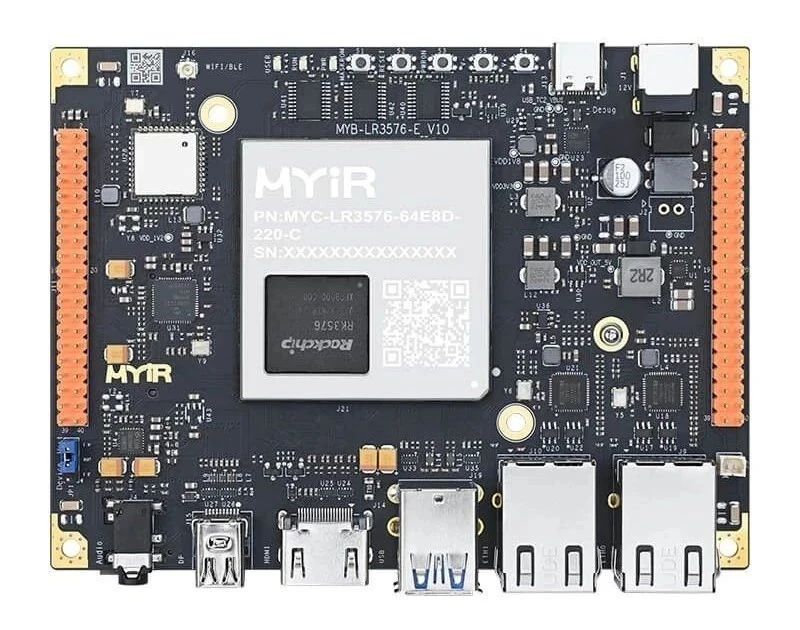

如何在RK3576開發(fā)板上運行TinyMaix :超輕量級推理框架--基于米爾MYD-LR3576開發(fā)板

http://www.sharifulalam.com 2025-07-25 11:45 來源:米爾電子

本文將介紹基于米爾電子MYD-LR3576開發(fā)平臺部署超輕量級推理框架方案:TinyMaix

摘自優(yōu)秀創(chuàng)作者-短笛君

TinyMaix 是面向單片機的超輕量級的神經(jīng)網(wǎng)絡推理庫,即 TinyML 推理庫,可以讓你在任意低資源MCU上運行輕量級深度學習模型。

關鍵特性

核心代碼少于 400行

(tm_layers.c+tm_model.c+arch_cpu.h),

代碼段(.text)少于3KB

低內存消耗

支持 INT8/FP32/FP16 模型,實驗性地支持 FP8 模型,支持 keras h5 或 tflite 模型轉換

支持多種芯片架構的專用指令優(yōu)化: ARM SIMD/NEON/MVEI,RV32P, RV64V

友好的用戶接口,只需要 load/run 模型

支持全靜態(tài)的內存配置(無需 malloc )

同樣地也可以部署到MPU平臺上

RK3576平臺相較于RK3588其主要縮減了四個A76大核改成了A72

GPU也由原來的G610 MC4減為了G52MC3

NPU功能保持變不變,均為6Tops

視頻編解碼也略有縮減

其余各接口也砍掉了一部分

主打極致性價比方案

說回正題,要運行TinaMaix 只需要簡單幾個步驟即可運行。

首先確保系統(tǒng)安裝了cmake gcc make工具:

克隆存儲庫[GitHub - sipeed/TinyMaix: TinyMaix is a tiny inference library for microcontrollers (TinyML).]

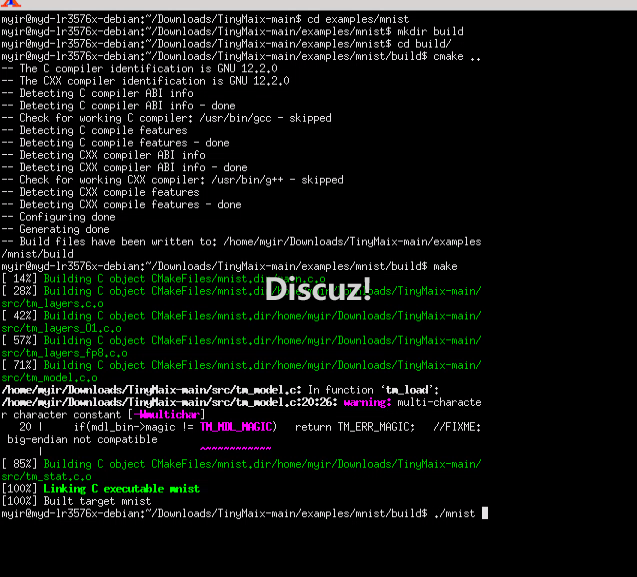

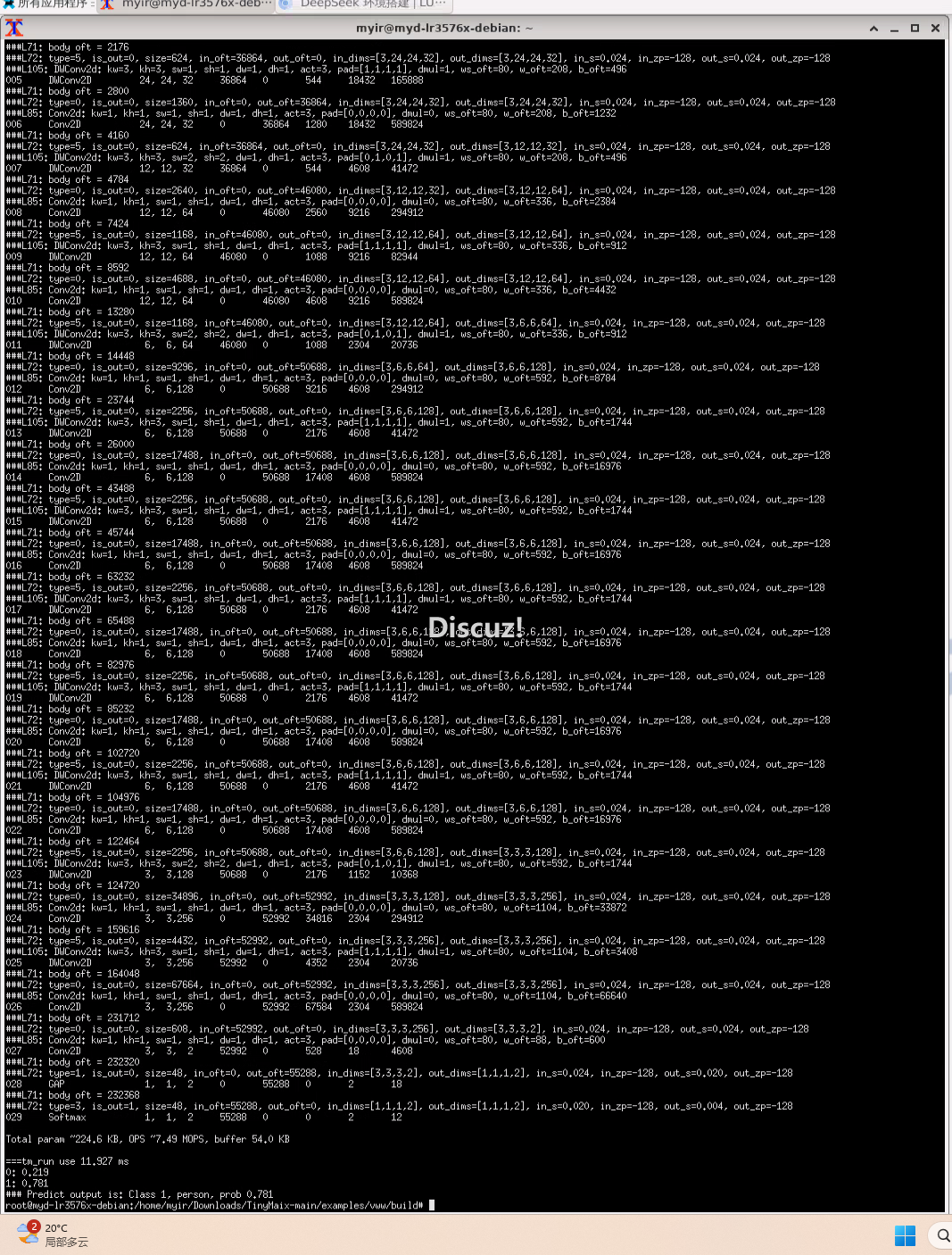

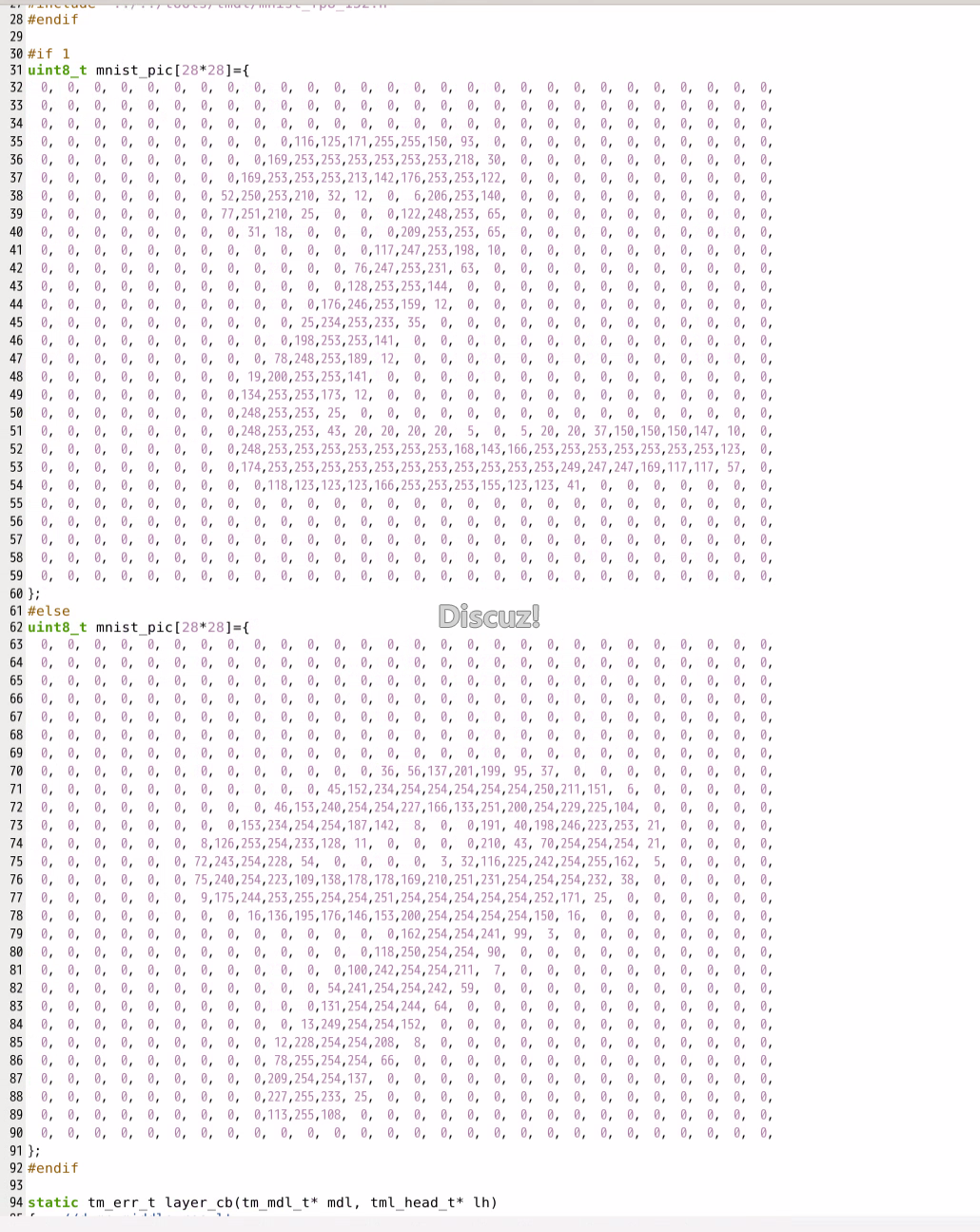

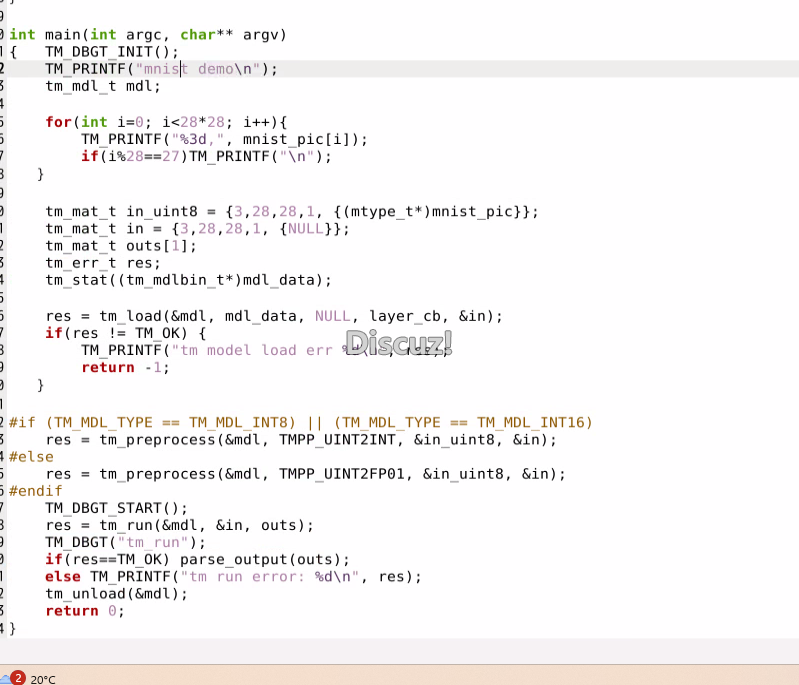

運行mnist手寫數(shù)字識別任務

cd examples/mnistmkdir buildcd build cmake ..make./mnist

整個流程跑完僅僅需要0.14ms

可以看到soc平臺強大的算力

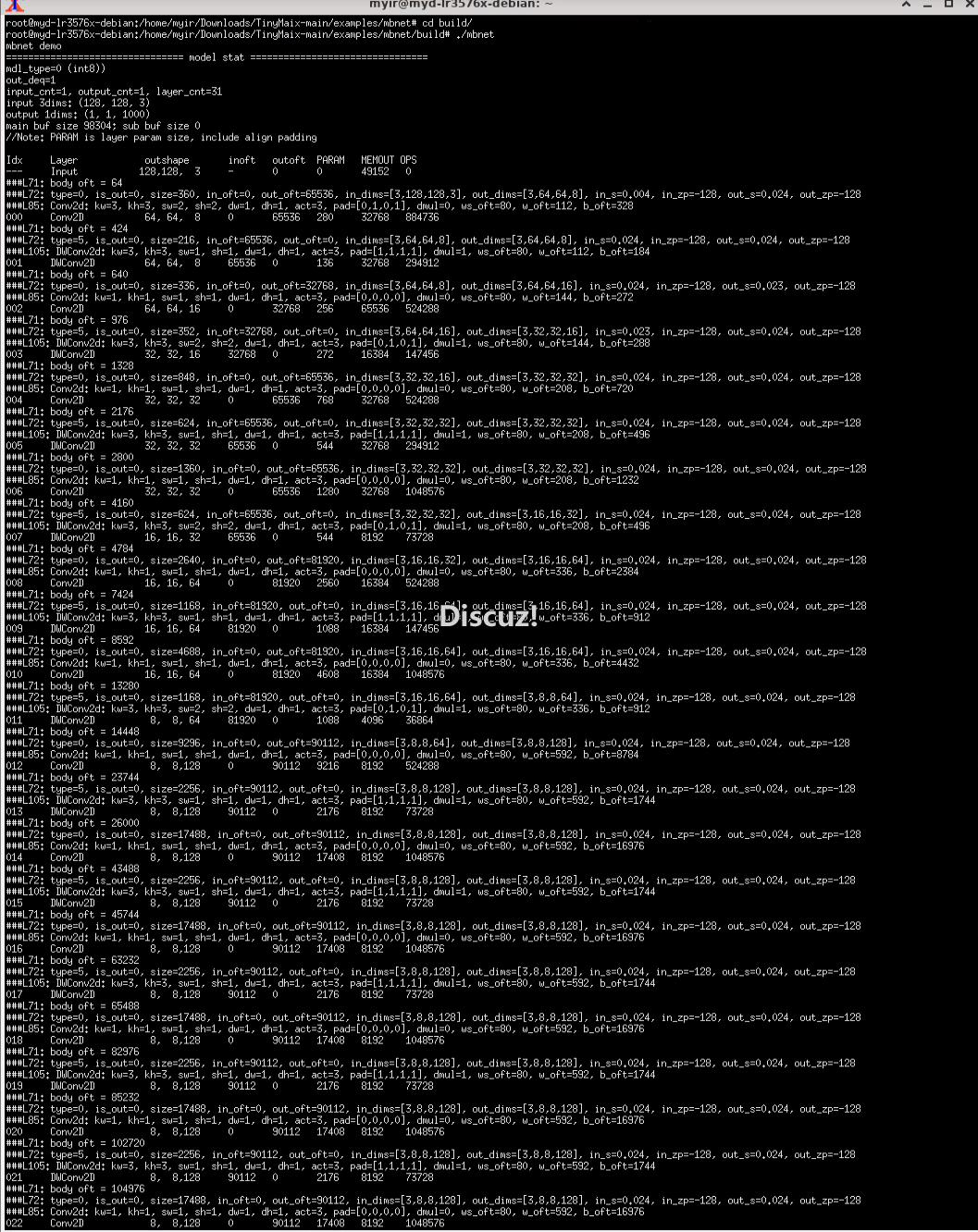

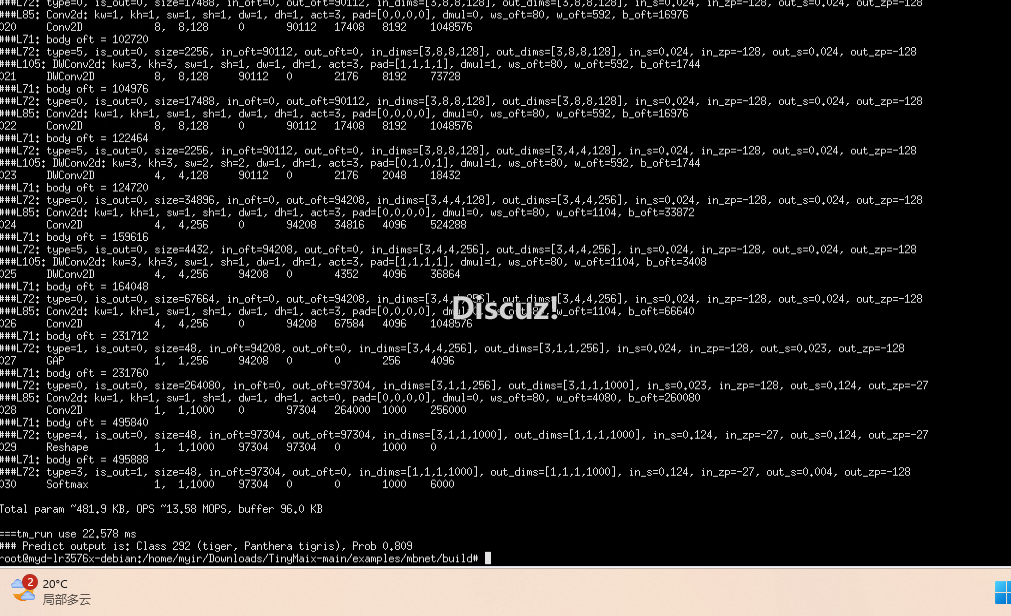

mbnet

是適用于移動手機設備的簡單圖像分類模型,不過對單片機來說也稍微困難了些。

例程里的模型是 mobilenet v1 0.25,輸入 128x128x3 的RGB圖像,輸出1000 分類的預測。

它需要至少 128KB SRAM 和 512KB Flash。

mkdir buildcd buildcmake ..make./mbnet

運行1000分類,耗費資源如下:

param “481,9 KB,0PS13,58 M0PS, buffer 96 0 KB

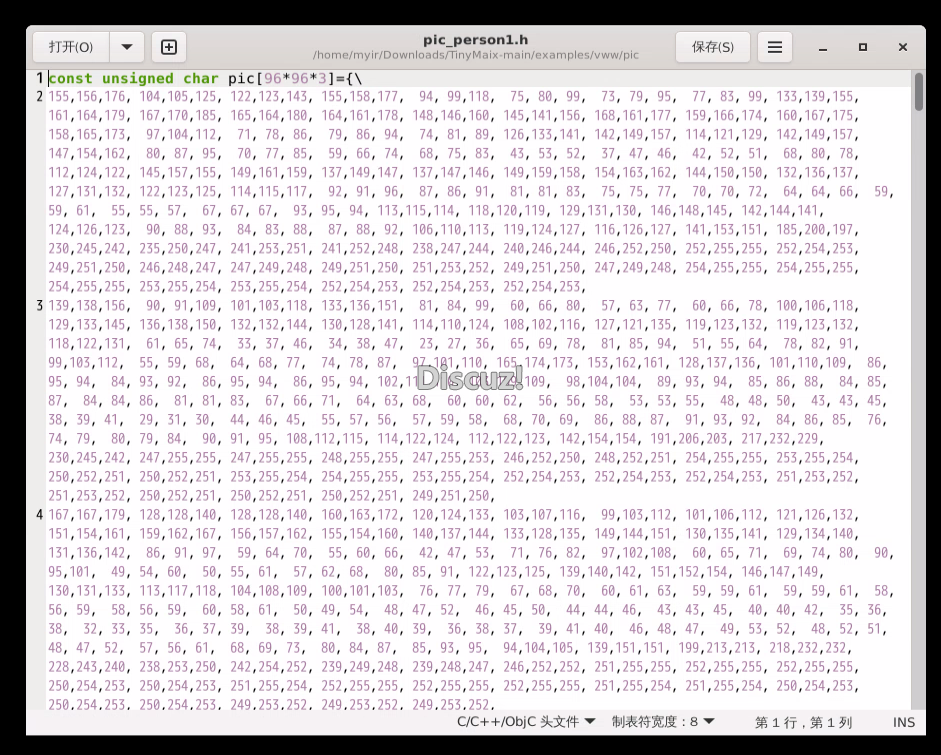

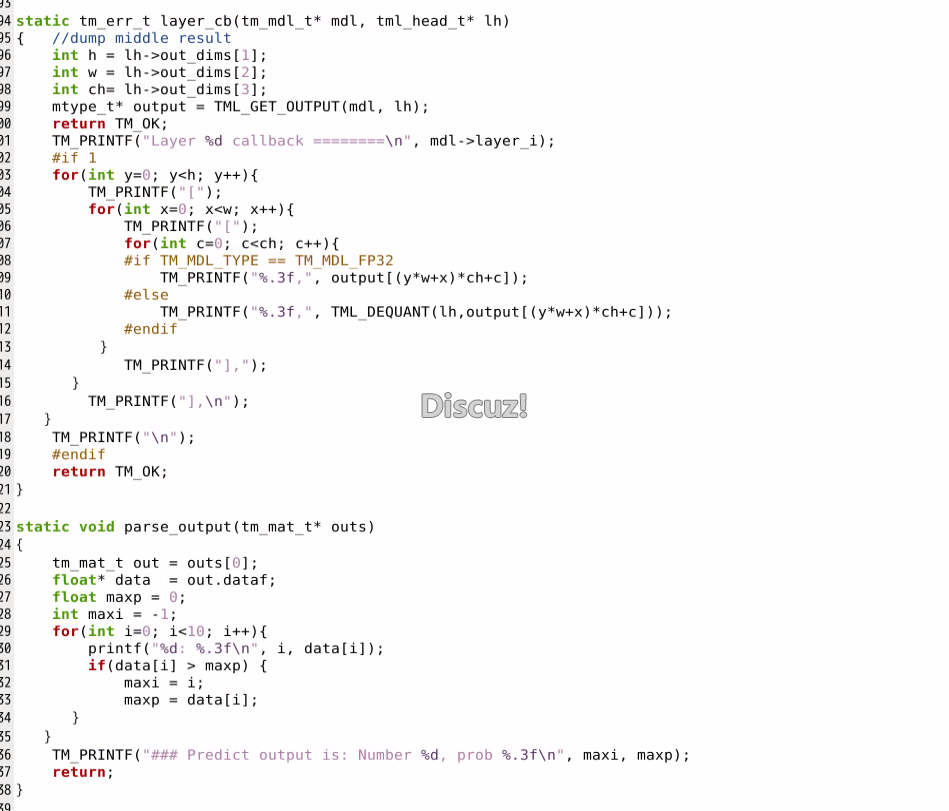

vww測試,主要是將圖片信息轉化為數(shù)組格式提供給網(wǎng)絡輸入。

手寫數(shù)字識別的例程也是十分簡單,只需要:

庫文件已經(jīng)是高度封裝且兼容,所以很輕松地就可以在linux以及其它平臺上移植,在RK3576這種高性能soc的加持下,可以發(fā)揮出更大的優(yōu)勢。

相關新聞

- ? RKDC2025 丨米爾亮相第九屆瑞芯微開發(fā)者大會,共繪工業(yè)數(shù)智新圖景

- ? 米爾將出席瑞芯微第九屆開發(fā)者大會

- ? 如何部署流媒體服務實現(xiàn)監(jiān)控功能--基于米爾TI AM62x開發(fā)板

- ? 米爾出席2025安路科技FPGA技術沙龍

- ? 新品!米爾NXP i.MX 91核心板開發(fā)板,賦能新一代入門級Linux應用

- ? 米爾RK3576核心板適配多種系統(tǒng),解鎖多樣化應用

- ? 3核A7+單核M0多核異構,米爾全新低功耗RK3506核心板發(fā)布

- ? 喜訊!米爾電子與安路科技達成IDH生態(tài)戰(zhàn)略合作,共筑FPGA創(chuàng)新生態(tài)

- ? 免費送30套開發(fā)板!米爾-安路飛龍派創(chuàng)意秀限時活動

- ? 一篇文章帶您玩轉T113的ARM+RISC-V+DSP三核異構!

編輯精選

- ? ABB推出三大全新機器人系列,強化中國機器人市場領導地位

- ? 臺達召開首屆“工業(yè)自動化技術大會”

- ? 霍尼韋爾成功舉辦首屆中國增長峰會 集全球智慧共筑本土創(chuàng)新

- ? 丹佛斯慶祝傳動北京研發(fā)中心成立20周年

- ? 2025年中國工業(yè)機器人行業(yè)市場前景預測研究報告

- ? 傳GE Vernova考慮出售工業(yè)軟件業(yè)務Proficy 售價高達10億美元

- ? 工業(yè)大模型應用進入廣泛探索階段,多方入局進入“百家爭鳴”時代

- ? 2025研華智能系統(tǒng)產(chǎn)業(yè)伙伴峰會成功舉辦

- ? 西門子新收購完成!工業(yè)驅動家族再擴充

- ? 強強聯(lián)手!港科大與比亞迪共建具身智能聯(lián)合實驗室

工控原創(chuàng)

- ? 2025數(shù)字化及智能制造技術論壇在青島圓滿落幕, 這些議題值得關注!

- ? ABB以本土化創(chuàng)新與AI賦能,引領中國機器人市場新篇章

- ? 一文get六月工控自動化大事

- ? ABB加速器中國周:當AI邂逅硬核工業(yè),一場自下而上的智造革命

- ? 點擊了解5月工控圈那些事兒

- ? 分拆上市還是出售?ABB機器人業(yè)務將何去何從

- ? 打造標桿案例及生態(tài)圈,ABB全力推動Ethernet-APL應用加速

- ? 你關心的四月份工控大事全在這里

- ? 匯川技術2024年財報解析:多元化布局彰顯增長韌性

- ? 關稅政策讓美國工業(yè)自動化復蘇之路面臨不確定性